(图片来源:SCMP)

AI芯片已经成为中美科技竞争中的重要“王牌”。

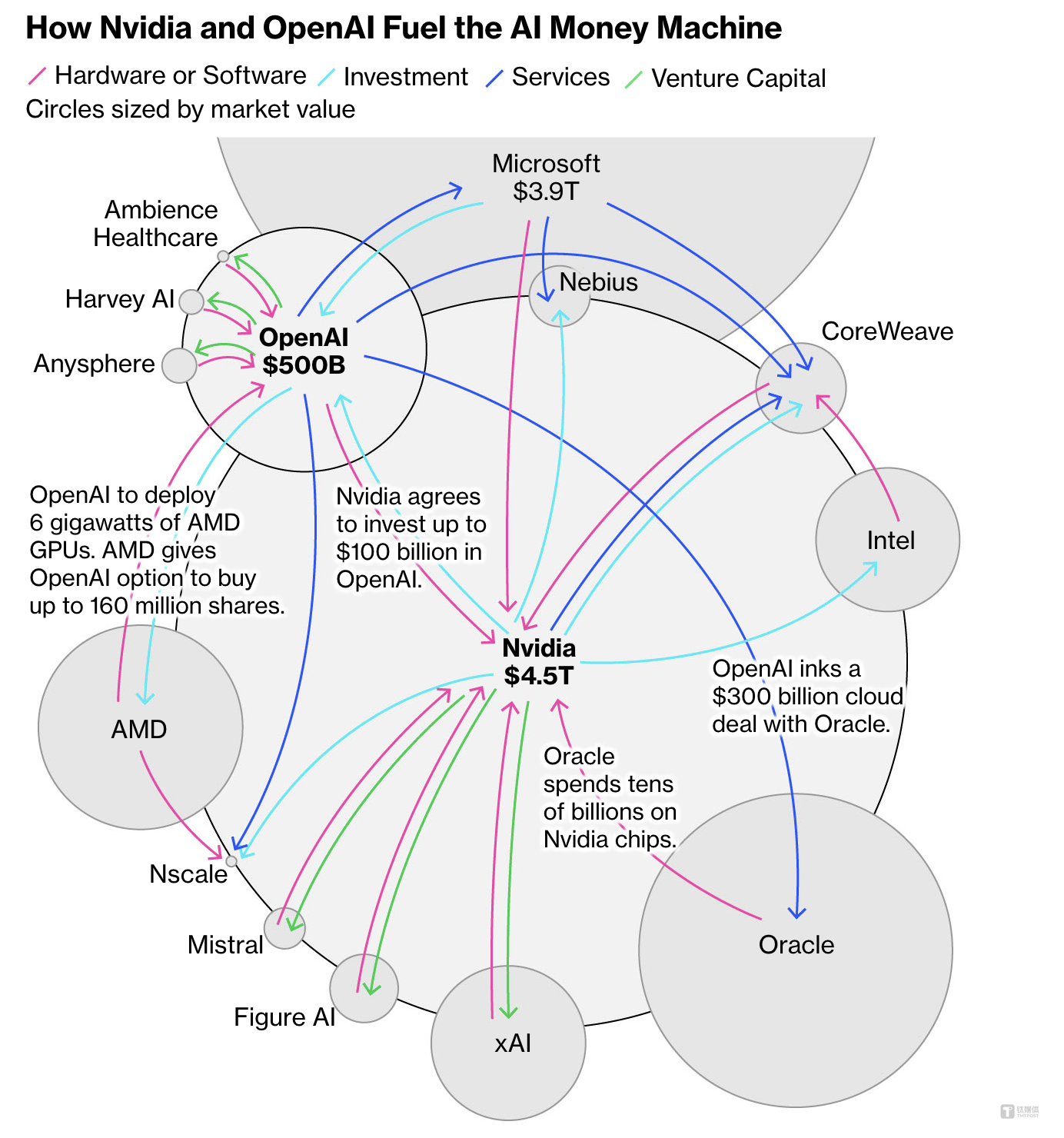

过去半个多月,高达4.5万亿美元市值的英伟达宣布,未来十年将向OpenAI投资至多1000亿美元,后者将购买和部署400万-500万块英伟达GPU芯片;同时,10月7日,AMD宣布与OpenAI达成了一项为期四年、价值数百亿美元的算力芯片供应协议,OpenAI将认购AMD最高10%的股份;甲骨文也和OpenAI达成万亿美元的合作协议。

AMD和OpenAI双方合作公布后,AMD股价一度暴涨,创下近十年来的最大涨幅,也让这家数据中心AI芯片市场的“千年老二”,首次与英伟达展开正面对战,并且让OpenAI形成了一场万亿“循环交易”。

国内方面,10月初,DeepSeek发布DeepSeek-V3.2-Exp模型,随后寒武纪、华为昇腾等国产芯片纷纷宣布适配,甚至华为还公布昇腾910系列芯片量产计划,2026年第一季度将推出昇腾950PR,采用华为自研HBM,到2028年第四季度推出将昇腾970。

另外,寒武纪股价不断升高,7-9月之间股价涨幅高达124%,最新市值达5210亿元,一度超过日本最大的芯片制造设备厂商东京电子,也成为国内A股市值最高的半导体设计公司之一。

英伟达CEO黄仁勋最新表示,中国在芯片领域仅落后美国“几纳秒”,芯片研发和制造方面具有极强的潜力。他呼吁美国政府允许美国科技企业在中国等市场竞争,以“提高美国的影响力”。

很显然,虽然美国不断加大对华AI芯片出口管制,却反而加速了国产AI芯片的迭代,也导致H20芯片在华遇冷。如今,尽管2024年英伟达产品占中国AI芯片销量三分之一以上,但黄仁勋团队仍陷入中美AI芯片竞争当中。

一方面,美国持续扩大对华 AI 芯片出口管制,例如最新的《GAIN AI》法案要求,英伟达 AI 芯片必须优先供应美国企业,之后才能向中国出口先进 AI 芯片,这可能导致英伟达错失价值 500 亿美元的中国 AI 算力市场 “大蛋糕”。

另一方面,市场竞争也在加剧:AMD、谷歌、微软、博通等国外企业,以及华为、寒武纪、摩尔线程等国内企业,纷纷研发出性价比更高的 AI 算力芯片产品,且国产AI算力芯片已逐步获得部署订单。此外,阿里、腾讯、百度、字节跳动等互联网大厂,也在加大芯片研发与设计投入,力求在供应链中掌握更强大的自主可控能力。

Epoch Al数据显示,过去一年,OpenAI在算力上斥资70亿美元,AI大模型训练占50亿美元。

摩根士丹利预测,未来三年,全球AI基础设施建设总成本可能高达3万亿美元(约合21万亿元人民币)。另据德勤报告,随着AI、5G等新技术蓬勃发展,2025年全球半导体产业销售收入将达到创纪录的6970亿美元,预计2030年销售规模将超过1万亿美元。

晨星公司分析师布莱恩·科莱洛 (Brian Colello) 表示,“如果一年后我们经历了AI泡沫并最终破裂,(英伟达投资OpenAI)这笔交易或许会成为早期线索之一。”

英伟达发言人在回应有关中国芯片公司近期进展的询问时表示,竞争无疑已经到来。

清华系AI芯片公司清微智能CEO王博对笔者表示,可重构等新架构AI芯片可以让国产AI算力拥有非英伟达GPU的发展之路。国内AI芯片市场需要在产品上具备比竞品5倍的性价比优势,才能分得更多的蛋糕。“行业现在有一个绝对占据市场份额的竞品,比如英伟达或英特尔,你是绝对不能按照它的路径走的,那会被碾压得渣都不剩。”

DeepSeek热潮带来国产AI芯片“超车”

自2022年10月以来,美国针对中国半导体行业发起多轮出口管制,企图让中国无法制造先进AI芯片,也无法使用美国芯片训练先进模型。

2024年12月,美国拜登政府任内最后一次扩大对华出口限制,包括限制对华出口先进AI芯片所需的HBM(高带宽存储),以及降低算力密度的红线,剑指限制中国AI大模型的发展能力。因此,此前还对英伟达芯片有较大依赖的中国互联网云公司,也都开始考虑部署国产AI芯片。

而与此同时,2025年的DeepSeek热潮,也加速了国内AI芯片和应用的落地。

今年8月,DeepSeek推出V3.1版本之时,官方写的一段话引起市场关注——“UE8M0 FP8是针对即将发布的下一代国产芯片设计”,使得市场不断关注国产AI芯片最新进展,同时也让英伟达股价应声下跌。

当前,DeepSeek训练成本远低于美国领先的AI模型。9月18日梁文锋担任通讯作者的权威期刊《自然》(Nature)封面论文显示,DeepSeek-R1模型训练成本仅为29.4万美元,即便加上约600万美元的基础模型成本,也远低于OpenAI、谷歌训练AI的成本。

黄仁勋今年7月对笔者表示,DeepSeek-R1既是一种革命性的模型,也是第一个开源的推理模型,而且非常创新。对于应用场景而言,中国AI模型非常高效且开放,可以根据任何应用场景来调整,甚至可以在这些开放模型基础上创建一家公司、一款产品或一项业务。

“四年前,英伟达在中国的市场份额高达95%,如今只有50%。如果我们不在中国竞争,而是让中国开发出新的平台,建立一个丰富的生态系统,并且它们不是美国的,在世界推广AI技术的时候,他们的技术和领导力将会传播到世界各地。”黄仁勋表示。

英伟达CEO黄仁勋

截至2024年底,英伟达占全球所有AI加速芯片销售规模的90%以上。据2025年8月最新季度财报显示,英伟达数据中心营收411亿美元,同比增长56%,成为英伟达营收占比最高的业务。

黄仁勋今年8月表示,英伟达Blackwell Ultra架构芯片的生产正在全速推进,需求很旺盛,恰逢推理型AI模型推动模型性能迅速增长。AI竞赛已经拉开帷幕,Blackwell是这场竞赛的核心。

他认为,每年与数据中心基础设施建设相关的6000亿美元资本开支,只计入了投入最大的四个厂商,此外还有大量公司会对AI进行相应投资,接下来5年,英伟达将通过Blackwell、Rubin等架构的芯片,抓住价值3万亿到4万亿美元的AI基础设施建设机会。随着时间推移,AI将会加速GDP增长。

然而,DeepSeek并非唯一一家不依赖美国技术的中国AI公司。随着美国对华限制不断加剧,阿里、腾讯、字节火山引擎等国内云厂商开始一边囤货英伟达GPU,一边尝试国产替代。

财报显示,由于美国限制对华销售H20,英伟达2026财年第一财季产生的H20库存支出高达45亿美元,第二财季销售额更是减少了40亿美元。

但同时,国产AI芯片市场却处于供不应求的状态。据悉,阿里、寒武纪、清微智能、摩尔线程、壁仞科技等多家国产AI芯片的目标是挑战英伟达,成为中国核心的AI算力芯片厂商之一。

近期,央视报道“中国联通三江源绿电智算中心项目建设成效”,其中就披露阿里旗下平头哥最新研发面向AI数据中心的PPU芯片,其各项主要参数指标均超过英伟达A800,与H20相当,同时消耗更少的能源。

据笔者了解,寒武纪目前最大的互联网客户为字节跳动,芯片预购订单超20万片;阿里和百度自研芯片已经量产;腾讯目前正在逐步上架此前囤积的芯片,同时还购买燧原产品。

今年9月,华为推出有史以来最强大的AI芯片。华为表示,2026年第一季度推出昇腾950PR,该芯片采用华为自研HBM;2026年第四季度推出昇腾950DT;2027年第四季度推出昇腾960芯片;2028年第四季度推出昇腾970,挑战英伟达在AI市场主导地位。

据财新,有半导体行业人士估算,2024年,华为昇腾AI芯片出货量约为30万-40万颗,寒武纪超1万颗;2025年,华为昇腾出货量或略低于100万颗,而寒武纪出货量将增至8万颗左右,预计2026年寒武纪出货量还能翻倍。

然而,华为副董事长、轮值董事长徐直军表示,由于受美国的制裁,华为不能到台积电去投片,单颗芯片的算力相比英伟达存在差距,但华为在超节点互联技术上强力投资、实现突破,能够做到万卡级的超节点,从而做到世界上算力最强。

华为公司创始人任正非今年6月表示,尽管华为昇腾芯片比美国同类产品“落后一代”,但它可以通过堆叠和集群等技术达到最先进的性能。

无论面临何种挑战,我们显然不能低估中国 AI 芯片的追赶能力。

摩尔线程创始人兼CEO张建中近期表示,当前GPU芯片的制造端困境主要有三方面——国际高端芯片禁运、高端HBM存储限售、先进工艺制程限制。今天市场大概有超过700万张GPU计算卡的需求,来支撑生成式AI和AI智能体技术能力。而未来5年,AI算力需求仍将保持100倍增长,以每一片晶圆大概产出20-30片有效算力来计算,中国还有300万张GPU卡的产能缺口,从中短期看,国内算力市场面临智能算力短缺,产能不太可能满足需求。

今年9月26日,摩尔线程提交招股书仅88天,就顺利过会,成为科创板最快审核的AI芯片公司,有望成为“国产GPU第一股”。此次IPO,摩尔线程计划募资80亿元人民币,是年内A股过会项目中募资规模最大的项目,同时也是年内半导体设计领域最大规模的IPO。公司表示,募集资金将主要投向新一代AI训练与推理芯片、图形芯片及AI SoC芯片的研发,以巩固其在高性能计算领域的领先地位。

财报显示,摩尔线程2025年上半年营业收入达7.02亿元,已超过前三年营收总和,近三年复合增长率超208%。公司毛利率从2022年的-70.08%大幅提升至2024年的70.71%。截至2025年6月30日,公司正在洽谈的客户预计订单合计将超过20亿元。公司管理层预计最早于2027年实现合并报表盈利。

当前,主流Al智能体一次简单任务调用大约消耗10万tokens,复杂任务调用可达100万tokens以上。截至2025年6月底,国内日均tokens消耗量已经突破30万亿,一年半时间增长300倍。

张建中强调,AI正迈入智能体时代,算力需求将迎来爆发式增长。

黄仁勋曾表示,AI是一个充满活力的创业、高科技、现代化产业。美国企业应该与中国自由贸易,否则就有可能在AI竞赛中将优势拱手让给中国。

研究机构IDC最新数据显示,2025上半年,中国AI加速服务器市场规模达到160亿美元,同比2024上半年增长超一倍;中国加速芯片已拥有超过190万张。预计到2029年,中国加速服务器市场规模将超过1400亿美元。

IDC认为,从加速技术角度来看,2025年上半年,NPU、CPU等非GPU卡的需求持续增长,增长速度远超GPU,占据30%的市场份额;而从品牌角度来看,国产AI芯片已进一步得到普及,约占整个市场份额的35%。

计算瓶颈已来,服务器芯片急需新架构新存储新通信

对于一台放置数据中心的服务器来说,计算(芯片算力)、通讯(超节点、NVLink)、存储(HBM、DDR等)是三个最核心的要素。

随着行业进入后摩尔时代,如果你想迭代一款AI芯片,就需要提升PPA——提升性能、降低功耗、缩小面积。

本质上,PPA的提升需要从架构设计、工艺选型、软件优化等多维度协同发力,核心思路是通过硬件创新与软硬协同,加快AI任务(如矩阵运算、特征提取)的处理速度、优化计算效率与数据流转效率,并且在满足 AI 计算需求的同时,实现PPA三者的平衡与突破。

然而当前,从制程上看,“摩尔定律”已处于放缓阶段。从成熟制程(如14nm)升级至先进制程(如7nm、4nm、3nm),AI算力性能提升幅度不及预期,而且芯片成本也陡然上升。

国际商业战略公司 (IBS) 首席执行官Handel Jones曾表示,设计28nm芯片的平均成本为4000万美元;而7nm芯片的成本高达2.17亿美元,5nm为4.16亿美元,3nm更是将耗资高达5.9亿美元。另据多个公开数据显示,预计3nm芯片整体设计和开发费用可能接近10亿美元(约合人民币72亿元),高价格背后主要体现在晶圆代工成本、研发投入、设备采购(尤其是EUV光刻机)和良率等多个方面。

同时,高通最新发布基于4nm制程的第四代骁龙8s,相比之前高通骁龙产品,通用计算(CPU)性能仅提升31%;最新制程和Chiplet技术的英特尔酷睿Ultra7 165H,相比前代10nm制程的酷睿i7-1370P,每瓦性能仅增长8%左右;而台积电最新N2制程的性能相比前代仅提升10%-15%。

显然,未来先进制程的发展并不会给AI芯片性能和性价比层面带来更大提升。今年GTC大会上,黄仁勋开始宣传大模型Token需求的激增来体现B200对于AI芯片市场重要性,而非芯片性能。

一位半导体行业人士在私下和笔者交流时也提到,国内不做先进制程是明智的,本身到12nm之后,制程对于性能提升没有那么明显了。因此,国内制造工艺可能在相当长的时间内仍会严重受限,如何解决在工艺受限情况下,持续发展芯片算力,是当前一个非常关键的课题。

所以,计算的瓶颈已来,服务器AI芯片急需新的架构、新的存储方案、新的通信网络手段,从而让AI芯片能力更强。

清华大学教授、中国半导体行业协会集成电路设计分会理事长魏少军曾直言,伴随外部禁止中国进行先进制程芯片研发,中国所能使用的制造技术不再像之前那样丰富。如今,中国芯片产业需要在技术创新上更为关注不依赖先进工艺的设计技术,包括架构的创新、微系统集成等。芯片企业需摒弃“路径依赖”,打造中国自己的产品技术体系,否则将永远无法摆脱跟在别人后面亦步亦趋的被动局面。

“如果只是沿用现有的芯片架构,大概率只能跟在别人后面,难以实现超越。”魏少军认为,包括中国在内的亚洲国家应放弃将英伟达GPU架构用于AI芯片开发,以减少对英伟达的技术依赖。他认为,亚洲国家在开发算法和大模型方面,仍在效仿美国,但这种模式限制了自主性,或将带来对美国技术产生依赖的风险,亚洲的战略必须与美国模式有所区别,尤其是在算法设计和计算基础设施等基础领域。

清华大学集成电路学院院长尹首一在AICC2025人工智能计算大会上表示,每一个晶体管能提供多少算力,本质上是计算架构的问题。采用新的计算架构,有机会去提高每个晶体管的利用率、解决制约国产芯片性能的存储墙,以及降低芯片功耗,带给芯片更多新的可能性,计算架构的破局有助于AI芯片算力提升。同时,用可重构计算架构去做AI计算,用软硬件编程方式,动态构造一个最适配的计算架构,有机会通过硬件自动化编程去逼近专用集成电路的性能。

“创新架构能够突破传统的设计思维,能够解决我们基础算力问题,但我们还需要有效的生态支撑。智源研究院的FlagOS是国产架构创新的生态后盾,我们的软硬协同共同努力两方面互补,从而能够突破中国算力‘卡脖子’挑战。”尹首一表示。

除了新架构,存储和通信的提升也至关重要。

其中,存储方面,HBM、DDR等AI存储芯片需求规模正呈现指数级扩张,一个GPU节点就可能消耗数百甚至数TB存储。据美光数据显示,AI服务器的DRAM容量需求是普通服务器的8倍,NAND闪存容量需求则达到3倍,单台AI服务器存储需求更是高达2TB,远超传统服务器的配置标准。

因此,需求激增直接推高存储芯片在AI基建中的成本占比。近期,OpenAI的“星际之门”(Stargate)项目与三星、SK海力士达成合作,每月需采购90万片DRAM晶圆,这一数字相当于全球DRAM总产量的近40%。

目前,HBM单颗价格超过5000美元,是传统DDR5内存的20倍,而毛利率却高达50%-60%,远超传统DRAM 30%左右的水平。

闪存市场总经理邰炜今年3月表示,AI浪潮下,计算平台正从CPU转移到以GPU/NPU为中心,存储芯片需求也将增长,因此HBM高带宽存储在AI时代中得到广泛应用,目前HBM在DRAM存储行业占比已接近30%,2026年HBM4将会推动行业更多定制化需求。

通信网络方面,英伟达的网络布局涵盖了三种主要技术NVLink、InfiniBand 和Ethernet,其中,NVLink是将GPU彼此连接在一台服务器内,或者在机柜状的服务器机架中连接多台服务器;而华为提出昇腾CLoudMatrix 384超节点,在高速互联总线联接下,共由12个计算柜和4个总线柜构成,算力总规模达300Pflops,是英伟达NVL72的1.7倍,网络互联总带宽达269TB/s,比英伟达NVL72提升107%,内存总带宽达1229TB/s,比英伟达NVL72提升113%,未来将进一步扩展为包含数万卡的Atlas 900 SuperCluster超节点集群,未来可以支撑更大规模的模型演进。

此外,很多AI芯片公司也在探索共封装光学(CPO)、Chiplet、光通讯网络、DPU等新的通信网络技术,通过互相通信更快提升整个AI算力性能。

北京智源人工智能研究院副院长兼总工程师林咏华表示,未来,我们需要推动更好的性价比、更低能耗、新的计算架构,持续性投入创新,让更多创新硬件有机会大范围使用,实现更大的商业价值。据悉,智源研究院近期联合全球生态伙伴推出“众智FlagOS v1.5”系统,清微智能与寒武纪、摩尔线程、昆仑芯、华为昇腾、中科海光共同成为国内唯六的“FlagOS卓越适配单位”。

然而当前,国产AI芯片生态尚不完善,产能严重不足,而且中国仍在囤积大量海外芯片。根据海关总署今年1月发布的数据,2024年中国集成电路进口总量将达到5492亿块,同比增长14.6%;全年集成电路(即芯片)进口总额为3850亿美元,同比增长10.4%,这一数字占全球芯片总产量的62%。相比之下,2024年中国原油进口额为3250亿美元。

IDC中国AI基础架构分析师杜昀龙认为,中国AI加速服务器市场正在经历规模扩张和本土替代的阶段。在高端算力效能与生态成熟度上仍需突破。未来竞争焦点将从单芯片性能转向系统能效比、开放生态协同和绿色算力成本控制。行业需避免低水平重复建设,通过技术协同与标准优化提升国际竞争力。(文|AI科技平凡者2025,作者|林志佳,编辑|盖虹达)